2024

01

微博热搜榜 排名 1.只有创新才能自强才能争先 排名 2.吴磊问赵今麦有男朋友了吗 排名 3.美国正在阻止中国获得算力 排名 4.中国航天器名字里有中国人才懂的含义 排名 5.昆明动物园猴山2只猫已移出 排名 6.发布女性隐私视频被认定侮辱罪 排名 7.被游客投诉烤鱼片摊主已进黑名单 排名 8.秦岚露背了 排名 9.买701号房交房变704业主怒嫌晦气 排名 10.杨紫说破两万跳女团舞 排名 11.军队文职成绩 排名 12.北京地震 排名 13.在火车上发疯之后全车厢都安静了 排名 14.这跟易烊千玺谈了有什么区别 排名 15.谷爱凌腿受伤 排名 16.三蹦子厂家称倒车请注意将推出英文版 排名 17.巩汉林发视频缅怀赵丽蓉 排名 18.初中妹妹8科成绩总分66 排名 19.新加坡免签一不小心就变穷光蛋 排名 20.日本东京湾4.8级地震 GitHub 热门榜单 排名 1:/zed-industries/zed 简介: 以思维的速度编写代码–Zed是Atom和Tree-sitter的创建者提供的高性能多人代码编辑器。 URL: https://github.com/zed-industries/zed 作者: zed-industries 排名 2:/byoungd/English-level-up-tips 简介: 一份高级英语学习指南,可能会让你受益匪浅🎉 . 离谱的英语学习指南/英语学习教程。 URL: https://github.com/byoungd/English-level-up-tips 作者: byoungd 排名 3:/ZHO-ZHO-ZHO/ComfyUI-InstantID 简介: ComfyUI的InstantID的非官方实现 URL: https://github.com/ZHO-ZHO-ZHO/ComfyUI-InstantID 作者: ZHO-ZHO-ZHO 排名 4:/goenning/google-indexing-script 简介: 脚本使您的网站在48小时内在谷歌上建立索引 URL: https://github.

微博热搜榜 排名 1.加快推动城市治理体系和治理能力现代化 排名 2.昆明动物园决定采用诱捕方式将猫移出猴山 排名 3.警方回应黄圣依杨子表哥直播间带货风波 排名 4.何以中国向海泉州 排名 5.三变正妻 前妻变三 排名 6.蔡磊夫妇捐助1亿元攻克渐冻症 排名 7.国家邮政局约谈极兔速递 排名 8.999感冒灵护你健康过大年 排名 9.英国女演员吃饼干花生过敏身亡 排名 10.昆明动物园曾被曝猴子杀死2只猫 排名 11.女童遭父亲虐待死亡案最新进展 排名 12.女子欲跳入猴山救猫被游客救下 排名 13.黑龙江回应建议向南方游客提供小份菜 排名 14.iPhone钱包可以访问NFC 排名 15.张卫健 我没事精神得很 排名 16.专家建议别花几十万回乡盖房子 排名 17.吴磊林亦扬 经常请吃饭的哥哥 排名 18.中国小动物保护协会称已出发前往昆明 排名 19.一只小熊猫拒绝了你的搭讪 排名 20.被害女童父亲称未成年凶手年后正常上学 GitHub 热门榜单 排名 1:/goenning/google-indexing-script 简介: 脚本使您的网站在48小时内在谷歌上建立索引 URL: https://github.com/goenning/google-indexing-script 作者: goenning 排名 2:/mlabonne/llm-course 简介: 使用路线图和Colab笔记本进入大型语言模型(LLM)的课程。 URL: https://github.com/mlabonne/llm-course 作者: mlabonne 排名 3:/ollama/ollama 简介: 在本地启动并运行Llama 2、Mistral和其他大型语言模型。 URL: https://github.com/ollama/ollama 作者: ollama 排名 4:/zed-industries/zed 简介: 以思维的速度编写代码–Zed是Atom和Tree-sitter的创建者提供的高性能多人代码编辑器。 URL: https://github.

微博热搜榜 排名 1.坚决遏制各类安全事故多发连发势头 排名 2.不要再把肉泡水里解冻了 排名 3.徐娇怼于正 排名 4.2024春运出行指南 排名 5.女子列车吧唧嘴3小时大爷崩溃 排名 6.祖国统一台湾当归 排名 7.世界之外正式公测 排名 8.减重100斤的贾玲惊呆潘斌龙 排名 9.苹果新增118个emoji 排名 10.徐娇 让人瘦到85是有多歹毒 排名 11.广州夫妻捡垃圾在城中村造了一个博物馆 排名 12.迪丽热巴告别花少 排名 13.科学家警告小心北极僵尸病毒 排名 14.库里落选全明星首发 排名 15.暴雪总裁今日离职 排名 16.春运第1天 排名 17.亚洲天王林俊杰 排名 18.逃犯加入日本国籍后回国就被抓 排名 19.女子遭研究生同学无视追讨礼金 排名 20.萌兰揉鼻子也太像个人了吧 GitHub 热门榜单 排名 1:/LiheYoung/Depth-Anything 简介: 深度任意:释放大规模无标签数据的力量 URL: https://github.com/LiheYoung/Depth-Anything 作者: LiheYoung 排名 2:/byoungd/English-level-up-tips 简介: 一份高级英语学习指南,可能会让你受益匪浅🎉 . 离谱的英语学习指南/英语学习教程。 URL: https://github.com/byoungd/English-level-up-tips 作者: byoungd 排名 3:/thijsvanloef/palworld-server-docker 简介: Docker容器,可轻松运行Palworld专用服务器。 URL: https://github.com/thijsvanloef/palworld-server-docker 作者: thijsvanloef 排名 4:/YangLing0818/RPG-DiffusionMaster 简介: 掌握文本到图像的扩散:使用多模式LLM(PRG)进行重新调整、规划和生成 URL: https://github.

微博热搜榜 排名 1.习近平对江西新余市火灾事故作出重要指示 排名 2.江西新余火灾事故新闻发布会 排名 3.网课入侵猝死老师女儿再发声 排名 4.我国高光谱综合观测卫星投入使用 排名 5.三星AI手机爱了 排名 6.虞书欣司机在高速上倒车 排名 7.美嘉被山根挡住的眼泪 排名 8.12306候补 排名 9.在暴雪时分定档 排名 10.民政部回复龙年不宜结婚 排名 11.女生腹泻后未在意5天后心脏停跳 排名 12.宁艺卓 多动症 排名 13.你单位宣布除夕放假了吗 排名 14.大龄二孩家庭 排名 15.胡塞武装发射导弹击中一艘美国军舰 排名 16.苹果在华放下身段 排名 17.在哈尔滨没搓上的澡在海南整上了 排名 18.马斯克称中国车企世界上最有竞争力 排名 19.美甲 丑甲 排名 20.江西新余致39死火灾原因 GitHub 热门榜单 排名 1:/apernet/OpenGFW 简介: OpenGFW是一种灵活、易用、开源的GFW在Linux上的实现 URL: https://github.com/apernet/OpenGFW 作者: apernet 排名 2:/mlabonne/llm-course 简介: 使用路线图和Colab笔记本进入大型语言模型(LLM)的课程。 URL: https://github.com/mlabonne/llm-course 作者: mlabonne 排名 3:/LiheYoung/Depth-Anything 简介: 深度任意:释放大规模无标签数据的力量 URL: https://github.com/LiheYoung/Depth-Anything 作者: LiheYoung 排名 4:/hiddify/hiddify-next 简介: 多平台自动代理客户端,支持Sing-box、X-ray、TUIC、Hysteria、Reality、Trojan、SSH等,是一款开源、安全、无广告的客户端。 URL: https://github.

背景 Stable Diffusion 在训练数据集之前,需要先对数据进行预处理。

本篇文章就是介绍如何对图像进行批量预处理。

图片上传 上传图像到你指定目录,我的目录时/mnt/smb/

打开SD-web地址,进入192.168.1.232:7861,选择附加功能,进行图像预处理

批量抠图 选择从目录进行批量处理 填写输入目录和输出目录 举例:

原本我的共享文件夹 地址是\\192.168.1.249\DB Training\ai-pre-photo\out-photo 将所有的 \\192.168.1.249\DB Training\ 改为 /mnt/smb/ 所有的 \ 改为 / 因此 需填写地址如下图:

选择抠图模型 滑倒最底部选择背景去除算法,选择你要使用的算法,我这边选择silueta算法,可以根据你自己的需求使用算法

执行生成 点击生成按钮,开始对图像批量处理

查看生成的图像 在对应的共享文件夹也可以查看

微博热搜榜 排名 1.扎实稳健推进中国式现代化建设 排名 2.张黎 举报前已做好最坏打算 排名 3.湖南暴雪已致1万多人受灾 排名 4.天舟七号运送的太空快递已被签收 排名 5.宁拆一座庙必毁这桩婚 排名 6.菲律宾总统称台湾是中国的一个省 排名 7.211硕士回应入职不到半年被裁 排名 8.中国中医药大会 排名 9.法国9岁男孩被遗弃后独自生活2年 排名 10.12306抢票 排名 11.华中农大黄飞若曾叫嚣有专业律师团 排名 12.情侣酒店走光索要10倍赔偿 排名 13.李胜利说要把权志龙带来柬埔寨 排名 14.爸爸把我买的车厘子送人了 排名 15.TT违反禁毒条例被禁赛25场 排名 16.新疆余震1104次 排名 17.6寸蛋糕用5斤车厘子店家道歉 排名 18.成都好大的雪 排名 19.C罗向中国球迷道歉 排名 20.一脚淘汰30亿人 GitHub 热门榜单 排名 1:/apernet/OpenGFW 简介: OpenGFW是一种灵活、易用、开源的GFW在Linux上的实现 URL: https://github.com/apernet/OpenGFW 作者: apernet 排名 2:/rustdesk/rustdesk 简介: 开源远程桌面,TeamViewer的替代品。 URL: https://github.com/rustdesk/rustdesk 作者: rustdesk 排名 3:/KRTirtho/spotube 简介: 🎧 开源Spotify客户端,不需要Premium也不使用Electron!适用于台式机和移动设备! URL: https://github.com/KRTirtho/spotube 作者: KRTirtho 排名 4:/thijsvanloef/palworld-server-docker 简介: Docker容器,可轻松运行Palworld专用服务器。 URL: https://github.

微博热搜榜 排名 1.读懂3820蕴含的有福密码 排名 2.下雪 排名 3.研究生劳务费 排名 4.当江浙沪遇上了古诗词 排名 5.微博旅游之夜 排名 6.鸡 你有没有为一块猪油拼过命 排名 7.微信红包并非转账认定赠与无需返还 排名 8.郎朗回应58岁建筑工人钢琴之约 排名 9.关于六寸蛋糕放5斤车厘子这件事 排名 10.华西医生说九成大肠癌是它引起的 排名 11.吴彦祖 亚裔芭比刻板印象 排名 12.女孩把馒头做成带馅的1天卖500个 排名 13.国家卫健委要求加强出生证管理 排名 14.杭州下雪 排名 15.尔滨冻梨之后又火了冻柿咖啡 排名 16.吃辣时流鼻涕 味觉性鼻炎 排名 17.会中文的韩国人和中国人都沉默了 排名 18.阿莫西林只对6种病症有效 排名 19.9只小麻雀整整齐齐挤在车轮上取暖 排名 20.勇敢的人先加王一博微信 GitHub 热门榜单 排名 1:/KRTirtho/spotube 简介: 🎧 开源Spotify客户端,不需要Premium也不使用Electron!适用于台式机和移动设备! URL: https://github.com/KRTirtho/spotube 作者: KRTirtho 排名 2:/rustdesk/rustdesk 简介: 开源远程桌面,TeamViewer的替代品。 URL: https://github.com/rustdesk/rustdesk 作者: rustdesk 排名 3:/mingrammer/diagrams 简介: 🎨 用于云系统架构原型设计的图即代码 URL: https://github.com/mingrammer/diagrams 作者: mingrammer 排名 4:/EbookFoundation/free-programming-books 简介: 📚 免费提供的编程书籍 URL: https://github.

微博热搜榜 排名 1.冰雪春天 排名 2.韩安冉女儿被确诊多动症 排名 3.终于知道高铁盒饭受众是谁了 排名 4.博士乘组一个意外发现改变太空授课 排名 5.2024首个暴雪蓝色预警 排名 6.浙江小姐姐买一个冻梨老板切块还装盒 排名 7.刘涛说害怕胡歌家的七只猫 排名 8.大熊猫和叶因伤暂停营业 排名 9.与恶魔有约 鬼怪剧情 排名 10.吃完葡萄不要马上喝水 排名 11.医生 我是病了不是饿了 排名 12.王俊凯 很后悔昨天睡觉了 排名 13.经常拥抱对身体有好处 排名 14.温州红十字会通报打工人嘴替视频 排名 15.海归姑娘回国卖烧麦一年卖出2个亿 排名 16.一个月跑步10小时收益最大 排名 17.梦境其实是可以控制的 排名 18.祈今朝 人狗恋 排名 19.焦虑症 口罩和塑料袋 排名 20.科目三值得上春晚吗 GitHub 热门榜单 排名 1:/RVC-Boss/GPT-SoVITS 简介: 1分钟的语音数据也可以用来训练一个好的TTS模型!(少镜头语音克隆) URL: https://github.com/RVC-Boss/GPT-SoVITS 作者: RVC-Boss 排名 3:/Andre0512/hon 简介: 海尔hOn的家庭助理集成:支持19种语言的海尔/Candy/Hoover家用电器,如洗衣机和空调。 URL: https://github.com/Andre0512/hon 作者: Andre0512 排名 4:/Andre0512/pyhOn 简介: 使用python控制hOn设备 URL: https://github.com/Andre0512/pyhOn 作者: Andre0512 排名 5:/Codium-ai/AlphaCodium 简介: 在CodeContest中超越大多数人类竞争对手的代码生成工具 URL: https://github.

微博热搜榜 排名 1.冰雪春天 排名 2.河南南阳一学校发生火灾已致13人遇难 排名 3.重庆姐弟坠亡案孩子生母现状 排名 4.相约冰雪 排名 5.偶遇周杰伦王俊凯一起逛街 排名 6.小男孩腿脚太快弄丢姥姥被妈妈灵魂拷问 排名 7.日本爆冷 排名 8.萧山通报郝劭文称女儿被霸凌事件 排名 9.哈佛女孩刘亦婷成为美国普通中产 排名 10.外媒报道赵丽颖辛芷蕾新片 排名 11.苹果成全球负债第二多的科技公司 排名 12.亳州文旅把妲己请过去了 排名 13.华中农大教授曾找举报同学交流 排名 14.张馨予近期状态 排名 15.新娘让两个弟弟穿裙子当伴娘 排名 16.12306回应成都至北京票价低至47元 排名 17.韩国人将翻拍长津湖 排名 18.王海举报小杨哥带货假五常大米 排名 19.3岁男童高烧惊厥幼师急得跪地拦车 排名 20.梁朝伟拒绝被叫daddy GitHub 热门榜单 排名 1:/ejoy/ant 简介: 蚂蚁游戏引擎 URL: https://github.com/ejoy/ant 作者: ejoy 排名 2:/TencentARC/PhotoMaker 简介: PhotoMaker URL: https://github.com/TencentARC/PhotoMaker 作者: TencentARC 排名 3:/RVC-Boss/GPT-SoVITS 简介: 1分钟的语音数据也可以用来训练一个好的TTS模型!(少镜头语音克隆) URL: https://github.com/RVC-Boss/GPT-SoVITS 作者: RVC-Boss 排名 4:/spatie/holidays 简介: 计算一下哪些日子你不必工作! URL: https://github.

微博热搜榜 排名 1.冰雪春天 排名 2.华中农大教师黄某某存在学术不端 排名 3.华中农大组建导师组负责黄某某研究生培养 排名 4.太空发快递可以当日达了 排名 5.女司机心脏病发作打120后失联110找到人 排名 6.黄飞若 排名 7.金莎 控梦 排名 8.来份华莱士 全年好运势 排名 9.11名研究生否认举报教授是被威胁 排名 10.高三艺考生292分拿下省状元 排名 11.被抽走板凳骨折女生已自愿退学 排名 12.安徽春晚小品跳科目三导演发声 排名 13.他不敢用力是看戒指嵌肉里怕你疼 排名 14.优酷 手握多部养老保险 排名 15.领队称小冻梨沉默是因为太紧张 排名 16.熬夜吃辣 长斑 排名 17.妲己 排名 18.狼队Fly断开连接 排名 19.分水果碰到人不在工位 排名 20.华中农大教师黄某某被停职 GitHub 热门榜单 排名 1:/xiaolai/everyone-can-use-english 简介: 人人都能用英语 URL: https://github.com/xiaolai/everyone-can-use-english 作者: xiaolai 排名 2:/TencentARC/PhotoMaker 简介: PhotoMaker URL: https://github.com/TencentARC/PhotoMaker 作者: TencentARC 排名 3:/mihonapp/mihon 简介: Android版免费开源漫画阅读器 URL: https://github.com/mihonapp/mihon 作者: mihonapp 排名 4:/netease-youdao/QAnything 简介: 基于任何内容的问答。 URL: https://github.

微博热搜榜 排名 1.冰雪春天 排名 2.新郎为宠妻办中式婚礼不料自己也入坑 排名 3.男大学生抽走女同学板凳致其骨折 排名 4.腊八蒜为啥是绿色的 排名 5.腊八节 排名 6.云南白药退出全部二级市场证券投资 排名 7.好难 我要吃面了 排名 8.许凯代言利郎LESSISMORE 排名 9.蔡少芬 难怪谢娜女儿叫跳跳 排名 10.大麦同意退款抢林俊杰变林子祥的票 排名 11.海底捞打毛线收费39到99 排名 12.华中农大称调查情况将向社会公布 排名 13.华中农大11名学生联名举报信长达125页 排名 14.仙剑六 端水 排名 15.车厘子降价仍不被买账 排名 16.iPhone15发售3个月仅掉价18.2% 排名 17.迪丽热巴徒手提行李箱惊呆辛芷蕾 排名 18.世界之外 男主叫我名字 排名 19.仙剑四首播评价 排名 20.女童送医后死亡其父被刑拘 GitHub 热门榜单 排名 1:/TencentARC/PhotoMaker 简介: PhotoMaker URL: https://github.com/TencentARC/PhotoMaker 作者: TencentARC 排名 2:/maybe-finance/maybe 简介: 个人理财应用 URL: https://github.com/maybe-finance/maybe 作者: maybe-finance 排名 3:/linexjlin/GPTs 简介: 泄露的GPT提示 URL: https://github.com/linexjlin/GPTs 作者: linexjlin 排名 4:/bleedline/aimoneyhunter 简介: 人工智能副业赚钱大集合,教你如何利用人工智能做一些副业项目,赚取更多额外收益。利用人工智能兼职赚钱的终极指南:学习如何利用人工智能进行一些很酷的兼职,并赚取一些额外的现金。查看英文版以了解更多见解。 URL: https://github.

微博热搜榜 排名 1.坚定不移走中国特色金融发展之路 排名 2.网红樊小慧直播称被前婆婆上门殴打 排名 3.新疆1558名因雪崩滞留旅客离开景区 排名 4.相约冰雪 排名 5.天猫今晚八点正式开卖 排名 6.2022届本科生平均月入近6千 排名 7.谢娜家吃饭的时候不允许看手机 排名 8.海底捞能打毛线了 排名 9.被爸妈夸爆的超值健康年货 排名 10.军人结婚当天三等功喜报送上门 排名 11.请和我的老公结婚 BTS 排名 12.特朗普称我要回来了 排名 13.晒被子后的太阳味是怎么来的 排名 14.国产剧终于癫成了我不认识的样子 排名 15.周一围从朱丹口误后停更微博 排名 16.10种嘌呤大户 高尿酸者少碰 排名 17.抢火车票不用自己设闹钟了 排名 18.欧阳娣娣说我来自中国 排名 19.谭爷爷出差花花开启自助餐模式 排名 20.云台山妲己 GitHub 热门榜单 排名 1:/xiaolai/everyone-can-use-english 简介: 人人都能用英语 URL: https://github.com/xiaolai/everyone-can-use-english 作者: xiaolai 排名 2:/maybe-finance/maybe 简介: 个人理财应用 URL: https://github.com/maybe-finance/maybe 作者: maybe-finance 排名 3:/danny-avila/LibreChat 简介: 增强的ChatGPT克隆:具有OpenAI、GPT-4 Vision、Bing、Anthropic、OpenRouter、Google Gemini、AI模型切换、消息搜索、langchain、DALL-E-3、ChatGPT插件、OpenAI功能、安全多用户系统、预设、完全开源的自托管功能。开发中的更多功能 URL: https://github.com/danny-avila/LibreChat 作者: danny-avila 排名 5:/DataTalksClub/data-engineering-zoomcamp 简介: 免费的数据工程课程! URL: https://github.

微博热搜榜 排名 1.冰雪春天 排名 2.女子与小伙裸聊后发截图命令对方网贷 排名 3.每周吃5个鸡蛋糖尿病高血压风险降低 排名 4.空军红鹰飞行表演队最新训练大片 排名 5.网友开始自制欢宜香了 排名 6.游本昌为了好剧本卖房 排名 7.韩剧请和我的老公结婚 排名 8.经期5个表现说明子宫很健康 排名 9.2架波音飞机在美国芝加哥机场相撞 排名 10.谭爷爷带花花看萌兰 排名 11.姥姥姥爷不上春晚可惜了 排名 12.朝鲜废除祖国和平统一委员会 排名 13.肖战一年只休息半个月 排名 14.安心丈夫拒绝同房 排名 15.年轻人入行装修月入4万 排名 16.户口簿上再婚能否登记为已婚 排名 17.家有儿女将开拍原班人马全员回归 排名 18.苹果被欧盟要求3月7日前完成分拆AppStore 排名 19.168元火锅套餐生菜只有1片叶子 排名 20.章若楠眼中的美女是辛芷蕾 GitHub 热门榜单 排名 1:/maybe-finance/maybe 简介: 个人理财应用 URL: https://github.com/maybe-finance/maybe 作者: maybe-finance 排名 2:/tachiyomiorg/tachiyomi 简介: 适用于Android的免费开源漫画阅读器。 URL: https://github.com/tachiyomiorg/tachiyomi 作者: tachiyomiorg 排名 3:/ThePBone/tachiyomi-extensions-revived 简介: 为Tachiyomi应用程序恢复已删除的源代码扩展。 URL: https://github.com/ThePBone/tachiyomi-extensions-revived 作者: ThePBone 排名 4:/krahets/hello-algo 简介: 《你好算法》:动画图解、一键运行的数据结构与算法教程,支持 Java、C++、Python、Go、JS、TS、C#、Swift、Rust、Dart、Zig等语言。 URL: https://github.

微博热搜榜 排名 1.坚决铲除腐败问题产生的土壤和条件 排名 2.苹果官网罕见大降价 排名 3.96110一定要接 没接到要打回去 排名 4.神十七乘组空间站吃播健身上新 排名 5.祝绪丹 女二 排名 6.50岁老妈爆改女儿变3000年战国美女 排名 7.应届生当上班主任之后 排名 8.白敬亭带你买年货 排名 9.涉嫌杀害华人妻子好莱坞富二代拒不认罪 排名 10.各地文旅局都疯了 排名 11.冰岛小镇流进岩浆 排名 12.丹麦国王腓特烈十世登基 排名 13.新闻女王赢麻了 排名 14.于正说祝绪丹开拍前辞演 排名 15.女生在731部队罪证陈列馆外送暖宝宝 排名 16.李现瘦了十几斤的秘密 排名 17.被哈尔滨12一盘的菜量震慑住了 排名 18.王鹤棣最喜欢挂檀健次身上 排名 19.女演员之间的惺惺相惜 排名 20.36元成本一锅做出了10道菜 GitHub 热门榜单 排名 1:/EpicGames/raddebugger 简介: 本机、用户模式、多进程、图形调试器。 URL: https://github.com/EpicGames/raddebugger 作者: EpicGames 排名 2:/danny-avila/LibreChat 简介: 增强的ChatGPT克隆:具有OpenAI、GPT-4 Vision、Bing、Anthropic、OpenRouter、Google Gemini、AI模型切换、消息搜索、langchain、DALL-E-3、ChatGPT插件、OpenAI功能、安全多用户系统、预设、完全开源的自托管功能。开发中的更多功能 URL: https://github.com/danny-avila/LibreChat 作者: danny-avila 排名 3:/xiaolai/everyone-can-use-english 简介: 人人都能用英语 URL: https://github.com/xiaolai/everyone-can-use-english 作者: xiaolai 排名 4:/KillianLucas/open-interpreter 简介: 计算机的自然语言界面 URL: https://github.

微博热搜榜 排名 1.把老一辈革命家开创的伟大事业继续推向前进 排名 2.台湾是中国一部分的基本事实不会改变 排名 3.微博之夜合照 排名 4.南北互跨式旅游地图 排名 5.张颂文回复杨紫 排名 6.张予曦为防走光在胸口插花 排名 7.卵巢是生殖系统中最早衰老的器官 排名 8.江苏省考成绩 排名 9.2024国考笔试放榜 排名 10.蔓越莓证明广西人嘴真严 排名 11.李宇春被裙子封印住了 排名 12.楼下起火爸爸抱女儿坠楼7岁女儿身亡 排名 13.杨紫三获微博Queen 排名 14.不管什么汪小姐 只管唐嫣喜欢粉色 排名 15.短期频繁聊天 排名 16.吴露可逃坐一起了 排名 17.张小斐 贾玲练出一身腱子肉 排名 18.国台办发言人评论台湾地区选举结果 排名 19.朱一龙微博King 排名 20.推动两岸关系和平发展推进祖国统一大业 GitHub 热门榜单 排名 1:/maybe-finance/maybe 简介: 个人理财应用 URL: https://github.com/maybe-finance/maybe 作者: maybe-finance 排名 2:/excalidraw/excalidraw 简介: 用于绘制手绘类图表的虚拟白板 URL: https://github.com/excalidraw/excalidraw 作者: excalidraw 排名 3:/atuinsh/atuin 简介: ✨ 神奇的贝壳历史 URL: https://github.com/atuinsh/atuin 作者: atuinsh 排名 4:/pandora-next/deploy 简介: Pandora云+Pandora服务器+共享聊天+BackendAPI代理+聊天2API+免费注册=PandoraNext。新的GPT(Gizmo)UI,一体化! URL: https://github.

微博热搜榜 排名 1.发展冰雪产业把群众冰雪运动热情保持下去 排名 2.霍尊复出 排名 3.主持人拒绝为芭比玩笑道歉 排名 4.扛着大型快递飞天的天舟六号下班啦 排名 5.许凯是懂接龙的 排名 6.马伊琍拍繁花三年没见过游本昌 排名 7.吴谢宇称愿给母亲家人两套房 排名 8.樊振东退赛 排名 9.警方通报大一女生校内坠楼身亡 排名 10.iPhone16Pro或加入电容式操作按钮 排名 11.亚洲最帅王子迎娶平民女孩 排名 12.沈腾句句不提贾玲句句都是贾玲 排名 13.刘德华下个月就要去超市上班了 排名 14.樱桃和车厘子到底有什么区别 排名 15.丫丫回国后模样爆改 排名 16.林园回应8000元炒股赚到数百亿 排名 17.魏如萱 可以叫姨不能叫姐 排名 18.睡觉中途醒了 不要看时间 排名 19.美方不得以任何形式介入台湾地区选举 排名 20.这居然是董子健 GitHub 热门榜单 排名 1:/mckaywrigley/chatbot-ui 简介: 面向所有人的开源人工智能聊天应用程序。 URL: https://github.com/mckaywrigley/chatbot-ui 作者: mckaywrigley 排名 2:/aaamoon/copilot-gpt4-service 简介: 将Github Copilot转换为ChatGPT URL: https://github.com/aaamoon/copilot-gpt4-service 作者: aaamoon 排名 3:/subquery/subql 简介: SubQuery是一个开放、灵活、快速、通用的web3数据索引框架。我们的使命是帮助开发人员创建未来的去中心化产品。 URL: https://github.com/subquery/subql 作者: subquery 排名 4:/meilisearch/meilisearch 简介: 一款快速搜索API,可轻松融入您的应用程序、网站和工作流程 URL: https://github.

微博热搜榜 排名 1.习近平举行仪式欢迎马尔代夫总统访华 排名 2.大一女生校内坠亡生前疑遭舍友辱骂 排名 3.特斯拉降价 排名 4.关于全面推进美丽中国建设的意见 排名 5.nova12出色蓝不住 排名 6.腾讯游戏全部断开 排名 7.英美联合空袭也门 排名 8.上海地铁明确非日常服饰进站会阻拦 排名 9.巩俐出演时尚主编 排名 10.医生谈贾玲整容式暴瘦 排名 11.国产三蹦子在国外炸街了 排名 12.第一次见男主把女主吊起来哄睡 排名 13.北京正式发布春节放假安排 排名 14.陈泽 一个亿 排名 15.老人女儿回应张馨予买气球 排名 16.贾玲健身教练发声 排名 17.谢娜烤火鞋被烧了 排名 18.95后女孩用700天逆袭成普通人 排名 19.也门爆炸视频 排名 20.俞敏洪用董宇辉完成了去董化 GitHub 热门榜单 排名 1:/aaamoon/copilot-gpt4-service 简介: 将Github Copilot转换为ChatGPT URL: https://github.com/aaamoon/copilot-gpt4-service 作者: aaamoon 排名 2:/keiyoushi/extensions 简介: Tachiyomi应用程序的源代码扩展。 URL: https://github.com/keiyoushi/extensions 作者: keiyoushi 排名 3:/keiyoushi/extensions-source 简介: Tachiyomi应用程序扩展的源代码。 URL: https://github.com/keiyoushi/extensions-source 作者: keiyoushi 排名 4:/microsoft/PowerToys 简介: Windows系统实用程序可最大限度地提高生产效率 URL: https://github.

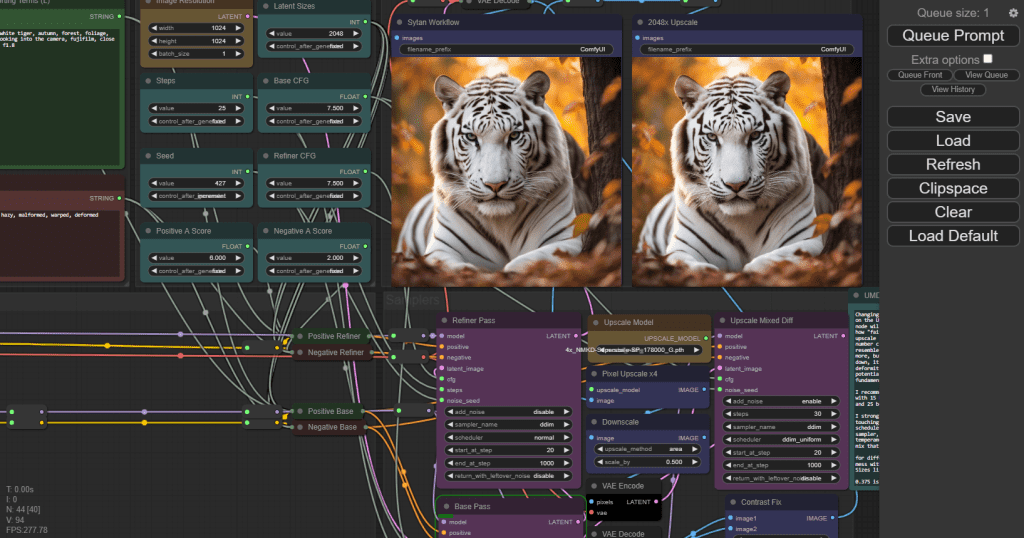

背景 ComfyUI 是用于稳定扩散的基于节点的用户界面。ComfyUI 由 Comfyanonymous 于 2023 年 1 月创建,他创建了该工具来学习稳定扩散的工作原理。

效果 webui和ComfyUI之间的区别,相比较webUI,ComfyUI更工业化,更符合高级使用者的配置

安装 安装本体 下载软件

1mkdir ~/sd-web 2cd ~/sd-web 3git clone https://github.jobcher.com/gh/https://github.com/comfyanonymous/ComfyUI.git 环境依赖

1cd ~/sd-web/ComfyUI 2conda create -n ComfyUI python=3.10 3pip install -r requirements.txt -i https://pypi.douban.com/simple --trusted-host=pypi.douban.com 下载sd_xl_turbo模型

1aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.jobcher.com/https://huggingface.co/stabilityai/sdxl-turbo/resolve/main/sd_xl_turbo_1.0_fp16.safetensors -d ~/sd-web/ComfyUI/models/checkpoints -o sd_xl_turbo_1.0_fp16.safetensors 启动服务

1cd ~/sd-web/ComfyUI 2python main.py --listen --port 6006 --cuda-device 1 webUI共享模型 1cd 2mv extra_model_paths.yaml..example extra_model_paths.yaml 编辑参数

1vim extra_model_paths.yaml 修改 base_path: path/to/stable-diffusion-webui/ 改为你的webui实际地址,例如: base_path: ~/sd-web/stable-diffusion-webui/ 1#config for a1111 ui 2#all you have to do is change the base_path to where yours is installed 3a111: 4 base_path: path/to/stable-diffusion-webui/ ## 这里改为你实际的webui地址 5 6 checkpoints: models/Stable-diffusion 7 configs: models/Stable-diffusion 8 vae: models/VAE 9 loras: | 10 models/Lora 11 models/LyCORIS 12 upscale_models: | 13 models/ESRGAN 14 models/RealESRGAN 15 models/SwinIR 16 embeddings: embeddings 17 hypernetworks: models/hypernetworks 18 controlnet: models/ControlNet 重启服务

微博热搜榜 排名 1.习近平同马尔代夫总统会谈 排名 2.近视眼从800度降到100度的过程 排名 3.霸王茶姬回应外卖按杯收取包装费 排名 4.这或许是对110最走心的定义 排名 5.25岁姑娘体检发现结节无症状确诊肺癌 排名 6.19岁的游本昌 排名 7.俩95后宝妈离婚后搭伙过日子 排名 8.为啥网上的药比实体药店更便宜 排名 9.水哥 我初中三年饱受校园暴力 排名 10.何猷君觉得父亲最帅的照片 排名 11.47岁男子没要到3000元生活费纵火烧家 排名 12.16岁女生讨要抚养费被亲戚打流产 排名 13.阿尔茨海默病新药国内定价每瓶2508元 排名 14.高启盛武器库 排名 15.晚上在家试了把王家卫镜头 排名 16.上影花5亿买基地支持繁花拍摄 排名 17.被萌兰33码小jiojio呼脸上了 排名 18.辛芷蕾金色吊带 排名 19.还好是他们七个人 排名 20.配货140多万没买到心仪爱马仕包 GitHub 热门榜单 排名 1:/aaamoon/copilot-gpt4-service 简介: 将Github Copilot转换为ChatGPT,免费使用GPT-4模型 URL: https://github.com/aaamoon/copilot-gpt4-service 作者: aaamoon 排名 2:/mckaywrigley/chatbot-ui 简介: 面向所有人的开源人工智能聊天应用程序。 URL: https://github.com/mckaywrigley/chatbot-ui 作者: mckaywrigley 排名 3:/LSPosed/LSPosed 简介: LSPosed框架 URL: https://github.com/LSPosed/LSPosed 作者: LSPosed 排名 4:/DataTalksClub/data-engineering-zoomcamp 简介: 免费的数据工程课程! URL: https://github.

微博热搜榜 排名 1.反腐败绝对不能回头不能松懈不能慈悲 排名 2.停止乱吃气血就回来了 排名 3.明年起连续5年没有年三十 排名 4.反腐大片持续发力纵深推进第四集 排名 5.朱丹咬过的肉给周一围吃 排名 6.李铁行贿300万当上国足主教练 排名 7.宝总李李真亲了 排名 8.警方辟谣网传人贩将一女孩双脚束缚 排名 9.街道办回应要求返乡过年人员要报备 排名 10.韩庚 今年哈尔滨明年牡丹江可好 排名 11.冬天起不来是身体在保护你 排名 12.仙剑3三美齐聚微博之夜 排名 13.贪官家被搜查时还有人敲门送礼 排名 14.李李出家 排名 15.男子打不着火被网友提醒房间缺氧 排名 16.专家建议尽快调整退休年龄 排名 17.我们为什么可以脱口而出110 排名 18.在职1万退休后只能拿4000 排名 19.早上宋慧乔 晚上宋小宝 排名 20.胡歌 国人自己的莱昂纳多 GitHub 热门榜单 排名 1:/aaamoon/copilot-gpt4-service 简介: 将Github Copilot转换为ChatGPT,免费使用GPT-4模型 URL: https://github.com/aaamoon/copilot-gpt4-service 作者: aaamoon 排名 3:/joaomdmoura/crewAI 简介: 用于编排角色扮演、自主人工智能代理的框架。通过培养协作智能,CrewAI使特工能够无缝协作,处理复杂任务。 URL: https://github.com/joaomdmoura/crewAI 作者: joaomdmoura 排名 4:/dreamoving/dreamoving-project 简介: DreaMoving的正式实施 URL: https://github.com/dreamoving/dreamoving-project 作者: dreamoving 排名 5:/DataTalksClub/data-engineering-zoomcamp 简介: 免费的数据工程课程! URL: https://github.

背景 Stable Diffusion (稳定扩散) 是一个扩散模型,2022年8月由德国CompVis协同Stability AI和Runway发表论文,并推出相关程序。

AUTOMATIC1111开发了图形化界面:「Stable Diffusion WebUI」,这是能用AI技术生成图片的开源软件,只要给定一组描述文本,AI就会开始绘图(准确的说是「算图」或「生图」);亦能模仿现有的图片,生成另一张图片。甚至给它一部分涂黑的图片,AI也能按照你的意愿将图片填上适当的内容。除此之外还支持自行训练模型加强生图效果。

本篇文章就是介绍如何安装 stable-diffusion-webui

安装conda 在 Ubuntu 上安装 Anaconda 的步骤如下:

首先,你需要下载 Anaconda 的安装包。你可以从 Anaconda 的官方网站上下载最新版本的 Anaconda for Linux。选择适合你的系统的版本(Python 3.x)。

访问下载链接:https://www.anaconda.com/products/distribution#download-section

下载完成后,你可以在终端中导航到下载的文件所在的目录。你可以使用 cd 命令来改变目录。例如,如果你的下载文件在 Downloads 文件夹中,你可以输入以下命令:

1cd ~/Downloads 然后,你需要运行 bash 命令来安装 Anaconda。假设你下载的 Anaconda 文件名为 “Anaconda3-2020.02-Linux-x86_64.sh”,你可以输入以下命令: 1bash Anaconda3-2020.02-Linux-x86_64.sh 请注意,你需要将上述命令中的 “Anaconda3-2020.02-Linux-x86_64.sh” 替换为你实际下载的文件名。

4. 接下来,你会看到 Anaconda 的许可协议。按 Enter 键滚动到底部,然后输入 ‘yes’ 来接受许可协议。

5. 然后,你需要确认 Anaconda 的安装位置。你可以选择默认位置或输入新的位置。 6. 安装完成后,你会看到一个提示,询问你是否希望 Anaconda3 添加到你的 PATH。你应该输入 ‘yes’。 7. 最后,你需要激活安装。你可以通过关闭并重新打开终端或运行以下命令来完成此操作:

1source ~/.bashrc 验证安装。在终端中输入以下命令: 1conda list 如果安装成功,这个命令会显示一个已安装的包的列表。

微博热搜榜 排名 1.打赢反腐败斗争攻坚战持久战 排名 2.年轻人报复性挤爆3.5分餐厅 排名 3.王家卫到底花了多少钱买歌 排名 4.多地上新文旅大礼包 排名 5.泡温泉会感染HPV吗 排名 6.贝肯鲍尔去世 排名 7.贾玲张小斐 我真的会谢 排名 8.沈阳文旅局局长连夜听网友支招 排名 9.女儿刚生爸妈坐高铁送2万6卖炸串钱 排名 10.北方袋装牛奶普遍没有吸管也没插孔 排名 11.卢美琳是嫁给黄河路的女人 排名 12.萝莉岛 排名 13.被开除当事人称公司全用盗版软件 排名 14.为什么全身面部的皮肤最差 排名 15.波音全球停飞股价暴跌 排名 16.乙流 排名 17.iPhone在华销量同比大跌30% 排名 18.景甜短发 排名 19.人间清醒是李湘 排名 20.爷叔给宝总上的最后一课 GitHub 热门榜单 排名 1:/MarkFzp/act-plus-plus 简介: 基于协同训练的移动ALOHA模拟学习算法:ACT、扩散策略、VINN URL: https://github.com/MarkFzp/act-plus-plus 作者: MarkFzp 排名 3:/DataTalksClub/data-engineering-zoomcamp 简介: 免费的数据工程课程! URL: https://github.com/DataTalksClub/data-engineering-zoomcamp 作者: DataTalksClub 排名 4:/joaomdmoura/crewAI 简介: 用于编排角色扮演、自主人工智能代理的框架。通过培养协作智能,CrewAI使特工能够无缝协作,处理复杂任务。 URL: https://github.com/joaomdmoura/crewAI 作者: joaomdmoura 排名 5:/aaamoon/copilot-gpt4-service 简介: 将Github Copilot转换为ChatGPT,免费使用GPT-4模型 URL: https://github.

微博热搜榜 排名 1.轨道上的京津冀加速形成 排名 2.我国破获一起英国秘密情报局间谍案 排名 3.马斯克回应吸毒 排名 4.中国在极地布放首个生态潜标 排名 5.辛芷蕾喝多了 排名 6.为什么网吧老板不会赶走蹭睡的人 排名 7.第一批小东北虎已抵达桂林 排名 8.胡歌 爆剧玄学 排名 9.公安机关发现余华英其他拐卖犯罪事实 排名 10.胖东来你装个红绿灯吧 排名 11.警犬父母生下幼犬取名110 排名 12.A先生说辛芷蕾本人很漂亮 排名 13.美国爱泼斯坦名单一窥 排名 14.贪官花40多万元建了条500米断头路 排名 15.做哈工大的学生也太幸福了 排名 16.等国考成绩 排名 17.雪乡导游强售套票未果让游客撅屁股等着 排名 18.涉事公司回应女高管违法开除员工 排名 19.傅菁接到粉丝爸爸电话的反应 排名 20.睿宝被爱宝凶了 GitHub 热门榜单 排名 1:/joaomdmoura/crewAI 简介: 用于编排角色扮演、自主人工智能代理的框架。通过培养协作智能,CrewAI使特工能够无缝协作,处理复杂任务。 URL: https://github.com/joaomdmoura/crewAI 作者: joaomdmoura 排名 2:/MarkFzp/act-plus-plus 简介: 基于协同训练的移动ALOHA模拟学习算法:ACT、扩散策略、VINN URL: https://github.com/MarkFzp/act-plus-plus 作者: MarkFzp 排名 3:/llenotre/maestro 简介: 用Rust编写的类Unix内核 URL: https://github.com/llenotre/maestro 作者: llenotre 排名 4:/dotnet/maui 简介: .

微博热搜榜 排名 1.以自强不息的精神奋力攀登 排名 2.女孩骨折忍痛赶飞机邻座是骨科主任 排名 3.iPhone电池门赔款到账 排名 4.全国各省份力拼经济开门红 排名 5.张若昀长文 排名 6.儿子身陷缅北父亲筹47万欲捞人被司法所劝住 排名 7.砂糖橘东北睡1宿变果脯 排名 8.陈丽华 女首富的格局 排名 9.尔滨这回真的来熊猫了 排名 10.贪官太嚣张另一个贪官都看不下去了 排名 11.花少北时隔2年再获百大 排名 12.女子多次仅退款后又偷取走快递 排名 13.死期将至 爆哭 排名 14.王家卫希望胡歌找回演李逍遥的感觉 排名 15.谢娜客串过苏有朋的左耳 排名 16.去哈尔滨的诱惑已打败艾莎公主 排名 17.健康人群午睡最好别超半小时 排名 18.张若昀 女团腿 排名 19.在中央大街摆摊的炸串老板道歉 排名 20.爱泼斯坦文件 GitHub 热门榜单 排名 1:/facebookresearch/audio2photoreal 简介: 从音频驱动的照片级逼真编解码器化身的代码和数据集 URL: https://github.com/facebookresearch/audio2photoreal 作者: facebookresearch 排名 2:/dotnet/maui 简介: .NET MAUI是。NET多平台应用程序UI,一个用于构建跨移动、平板和桌面的本地设备应用程序的框架。 URL: https://github.com/dotnet/maui 作者: dotnet 排名 4:/MarkFzp/mobile-aloha 简介: Mobile ALOHA:学习低成本全身远程操作的双手移动操作 URL: https://github.com/MarkFzp/mobile-aloha 作者: MarkFzp 排名 5:/MarkFzp/act-plus-plus 简介: 基于协同训练的移动ALOHA模拟学习算法:ACT、扩散策略、VINN URL: https://github.

微博热搜榜 排名 1.泱泱中华历史何其悠久文明何其博大 排名 2.家属已知复旦留美博士流浪纽约街头 排名 3.预算18w去哈尔滨 排名 4.中国航天员26年出征太空12次 排名 5.南方人吃冻梨削皮看傻东北网友 排名 6.警方辟谣哈尔滨放开南方小土豆放烟花 排名 7.孙东旭再现扔东西动作后赶紧纠正 排名 8.龙年提前见龙接好运 排名 9.易烊千玺从喝奶到喝香槟 排名 10.孙燕姿妹妹发文断绝关系 排名 11.刘宇宁直播门票 排名 12.百事被家乐福封杀 排名 13.日本又连发地震 排名 14.家长半夜给班主任打电话学生遭怒怼 排名 15.霍金 排名 16.papi酱菱红下线 排名 17.最糟糕的睡姿 排名 18.广西砂糖橘摆盘炫出花了 排名 19.陈楚生周深爆改声生不息 排名 20.孙燕姿妹妹曾多次发文对姐姐不满 GitHub 热门榜单 排名 1:/myshell-ai/OpenVoice 简介: MyShell的即时语音克隆。 URL: https://github.com/myshell-ai/OpenVoice 作者: myshell-ai 排名 2:/gunnarmorling/1brc 简介: 1.️⃣🐝🏎️ 十亿行挑战——有趣地探索如何使用Java快速聚合文本文件中的1B行 URL: https://github.com/gunnarmorling/1brc 作者: gunnarmorling 排名 3:/janhq/jan 简介: Jan是ChatGPT的开源替代品,它在您的计算机上100%离线运行 URL: https://github.com/janhq/jan 作者: janhq 排名 4:/shidahuilang/shuyuan 简介: 香色闺阁+阅读3书源+源阅读+爱阅书香+花火阅读+读不舍手+IPTV源+IPA巨魔应用=自动更新 URL: https://github.

微博热搜榜 排名 1.习近平向伊朗总统致慰问电 排名 2.iPhone16Pro渲染图曝光 排名 3.腾讯破30000的四部剧 排名 4.全国首个陆缆穿海工程 排名 5.花少5直接打包去中餐厅 排名 6.五天前vs五天后看繁花 排名 7.哈尔滨惊现15元1个小土豆挂件 排名 8.花花玩肚子上的肉肉 排名 9.杭州姑娘一句想吃冻梨司机直接下车买 排名 10.韩国年轻人不结婚的理由 排名 11.繁花宝总全名叫什么 排名 12.日本记者吐槽民众给震区寄千纸鹤 排名 13.网曝贵阳一马路上夜间多人爬行 排名 14.沈阳文旅局长在线截胡小砂糖橘们 排名 15.哈尔滨一33岁患癌女子离家出走 排名 16.繁花里出现了18岁的马伊琍 排名 17.收红包时的高情商回复 排名 18.女子分享自己7旬爷爷老来得子 排名 19.鄂伦春自治旗人大常委会主任感谢网友 排名 20.广西北海地震 GitHub 热门榜单 排名 1:/myshell-ai/OpenVoice 简介: MyShell的即时语音克隆。 URL: https://github.com/myshell-ai/OpenVoice 作者: myshell-ai 排名 2:/mlabonne/llm-course 简介: 使用路线图和Colab笔记本进入大型语言模型(LLM)的课程。 URL: https://github.com/mlabonne/llm-course 作者: mlabonne 排名 3:/gunnarmorling/1brc 简介: 1.️⃣🐝🏎️ 十亿行挑战——有趣地探索如何使用Java快速聚合文本文件中的1B行 URL: https://github.com/gunnarmorling/1brc 作者: gunnarmorling 排名 4:/donnemartin/system-design-primer 简介: 学习如何设计大型系统。为系统设计面试做准备。包括安基抽认卡。 URL: https://github.

微博热搜榜 排名 1.共同谱写中国式现代化的壮美华章 排名 2.11个砂糖橘外套是家长选的 排名 3.哈尔滨为小土豆连夜撤下破旧公交牌 排名 4.程序员回乡种小时候味道的西红柿 排名 5.农业银行 系统 排名 6.范湉湉繁花演技 排名 7.哈尔滨给中央大街铺地毯了 排名 8.南京地铁 排名 9.尔滨 你这凤凰搁辽宁那借的啊 排名 10.王家卫受害者联盟进新人了 排名 11.月入过万在江苏是什么体验 排名 12.小杨哥徒弟红绿灯的黄再次复播 排名 13.脸上出现5个症状暗示肝不好 排名 14.人民日报评哈尔滨旅游出圈 排名 15.尔滨背刺了整个东北 排名 16.南方小土豆这一称呼合适吗 排名 17.中国银行纪念币 约不到 排名 18.民警多问一句竟发现2名被拐孩子 排名 19.扎克伯格耗巨资挖末日地堡 排名 20.繁花 没人相信自己要杀青了 GitHub 热门榜单 排名 1:/myshell-ai/OpenVoice 简介: MyShell的即时语音克隆。 URL: https://github.com/myshell-ai/OpenVoice 作者: myshell-ai 排名 2:/mlabonne/llm-course 简介: 使用路线图和Colab笔记本进入大型语言模型(LLM)的课程。 URL: https://github.com/mlabonne/llm-course 作者: mlabonne 排名 4:/praydog/UEVR 简介: 通用虚幻引擎VR Mod(4/5) URL: https://github.com/praydog/UEVR 作者: praydog 排名 5:/donnemartin/system-design-primer 简介: 学习如何设计大型系统。为系统设计面试做准备。包括安基抽认卡。 URL: https://github.

微博热搜榜 排名 1.新年新的开始新的征途 排名 2.孩子甲流刚好又中招乙流 排名 3.苹果市值一夜蒸发7660亿元 排名 4.航天员太空开饭前互飞饺子 排名 5.逆龄世家之夜 排名 6.警方通报高校干部酒后家暴打死妻子 排名 7.鄂伦春族都请来了 排名 8.太超前了尔滨 排名 9.周一围 这次赶上朱丹的嘴 排名 10.19岁景甜的西雅图vlog 排名 11.怪力侄女 病娇叔叔 排名 12.上海调整公积金个人住房贷款政策 排名 13.7年情侣上恋综被所有人劝分 排名 14.未来一周日本可能还有强震 排名 15.美国哈佛大学校长宣布辞职 排名 16.偶像剧顶配 排名 17.郭麒麟亲了郭德纲一口 排名 18.日本以业务过失致人伤亡嫌疑调查飞机事故 排名 19.董事长发的红包被我一个人领了 排名 20.萌兰在院子里挖了4年宝贝 GitHub 热门榜单 排名 1:/mlabonne/llm-course 简介: 使用路线图和Colab笔记本进入大型语言模型(LLM)的课程。 URL: https://github.com/mlabonne/llm-course 作者: mlabonne 排名 2:/donnemartin/system-design-primer 简介: 学习如何设计大型系统。为系统设计面试做准备。包括安基抽认卡。 URL: https://github.com/donnemartin/system-design-primer 作者: donnemartin 排名 3:/KRTirtho/spotube 简介: 🎧 开源Spotify客户端,不需要Premium也不使用Electron!适用于台式机和移动设备! URL: https://github.com/KRTirtho/spotube 作者: KRTirtho 排名 4:/myshell-ai/OpenVoice 简介: MyShell的即时语音克隆。加入我们的Discord社区https://discord.

微博热搜榜 排名 1.足迹2023 排名 2.今天凌晨太阳爆发一个强耀斑 排名 3.床癌 排名 4.元旦起这些新规施行 排名 5.7系尖子生飞凡F7全面焕新 排名 6.赵露思 终于知道邓超上春晚的感觉了 排名 7.百度宣布终止收购YY直播 排名 8.王家卫拍出了辛芷蕾的人生镜头 排名 9.陈妍希兑现瘦十斤flag 排名 10.iPhone为什么只有P大写 排名 11.广东一地公示8名躺平休闲人员 排名 12.成都雾霾 排名 13.日本多个核电站燃料池水溢出 排名 14.黄晓明小海绵亲子装 排名 15.从此排骨是排骨 年糕是年糕 排名 16.日本地震震区中国游客夫妇发声 排名 17.王彦霖认证王鹤棣是单身 排名 18.杨迪檀健次 P图 排名 19.日本导演竹内亮地震后发声 排名 20.一个月不换的床单有多脏 GitHub 热门榜单 排名 1:/movie-web/movie-web 简介: 一个用于轻松观看电影和节目的小型网络应用程序 URL: https://github.com/movie-web/movie-web 作者: movie-web 排名 2:/dvmazur/mixtral-offloading 简介: 在Colab或消费型台式机中运行Mixtral-8x7B型号 URL: https://github.com/dvmazur/mixtral-offloading 作者: dvmazur 排名 3:/janhq/jan 简介: Jan是ChatGPT的开源替代品,它在您的计算机上100%离线运行 URL: https://github.com/janhq/jan 作者: janhq 排名 4:/twentyhq/twenty 简介: 以社区为动力,构建Salesforce的现代替代方案。 URL: https://github.

微博热搜榜 排名 1.二〇二四年新年贺词 排名 2.愿逆风如解意 税后十个亿 排名 3.新年快乐 排名 4.央视跨年晚会 排名 5.如果给2023一个关键词 排名 6.杨紫李现合照 今夕是何年 排名 7.跨年收视率 排名 8.谁是2024跨年晚会最忙艺人 排名 9.上海迪士尼发文致歉 排名 10.迪丽热巴新年首套高定 排名 11.两个小朋友你们被警方点名表扬了 排名 12.2024 排名 13.假唱 排名 14.为裁员西安某公司从CBD搬进秦岭山区 排名 15.梅德韦杰夫预测2024年 排名 16.许嵩冯禧同台 排名 17.宋茜唱跳给Amber镜头 排名 18.赵露思 敦煌神女 排名 19.湖南卫视 全是广告 排名 20.新街口全是人 GitHub 热门榜单 排名 1:/movie-web/movie-web 简介: 一个用于轻松观看电影和节目的小型网络应用程序 URL: https://github.com/movie-web/movie-web 作者: movie-web 排名 2:/donnemartin/system-design-primer 简介: 学习如何设计大型系统。为系统设计面试做准备。包括安基抽认卡。 URL: https://github.com/donnemartin/system-design-primer 作者: donnemartin 排名 3:/KRTirtho/spotube 简介: 🎧 开源Spotify客户端,不需要Premium也不使用Electron!适用于台式机和移动设备! URL: https://github.com/KRTirtho/spotube 作者: KRTirtho 排名 4:/lllyasviel/Fooocus 简介: 注重提示和生成 URL: https://github.